Voici la vidéo du Xyloberry, prise sur le stand d’Ordileers du Formum des associations, le 2 septembre 2018.

Le projet est visible au club sur demande.

Voici la vidéo du Xyloberry, prise sur le stand d’Ordileers du Formum des associations, le 2 septembre 2018.

Le projet est visible au club sur demande.

Cet été, nous nous sommes lancés dans un projet innovant.

Nous souhaitons faire jouer du Xylophone à un Raspberry. Ce projet implique de nombreuses disciplines pour être mené à bien :

Nous avons comme objectif de présenter notre réalisation au forum des associations de Leers, en septembre. Vous pouvez suivre l’avancement du projet sur la page Facebook d’Ordileers.

Prêts à relever un défi, et à rejoindre notre équipe de “Makers” ?

Sur la photo, le prototype du support 3D et un percuteur (électroaimant).

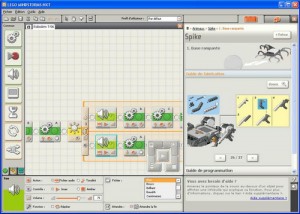

Nous sommes arrivés au bout des tutoriaux. En cherchant un peu sur le site web nous sommes tombés sur 2 montages intéressants. Ces montages sont intéressants car ils sont fournis chacun avec 2 programmes : un simple et un complexe. Cela va nous permettre de monter un peu dans la connaissance des possibilités du robot. Nous avons donc commencé par le montage de « boîte a bruit ». L’intérêt de ce montage réside dans l’utilisation d’un lien, dans le programme entre 2 propriétés de composant. Cela nous a permis de voir qu’il s’agissait d’une espèce de « binding ». Cela relie l’angle d’un moteur au volume d’un son. Par contre nous avons été génés par la mémoire disponible dans le robot. Pour pouvoir télécharger le programme on a dû remplacer un son par un autre plus petit. Cela fait un peu peur pour la version complexe du programme (que nous n’avons pas encore regardée). Il va être urgent de passer à un soft qui place l’IA dans le PC et non dans le robot (Visual Studio for Robotics certainement).

|

[youtube video=’iQZH4TSvIM4′ vparams=’rel=0|border=0′][/youtube]

|

Travail sur |

|

[youtube video=’k4oKe7TTIsw’ vparams=’rel=0|border=0′][/youtube]

|

L’étape de programmation avait les éléménts nouveaux suivant :

Bon … le résultat n’était pas fameux. En effet pour un danceur de smurf c’était bon mais pas pour un marcheur. S’étant apperçu que les pieds n’adhérés pas assez au sol, nous lui avant fait des semelles anti-dérapentes (des petits freins en fait) (voir figure 1). Au final c’était dû à une erreure minime dans le montage : 1 cran de déclage dans une articulation. |

Aprés présentation aux absents du travail effectué à la scéance précédente, nous nous sommes attaqués au 3ème modèle. Il s’agit d’un scorpion! C’est un engin mobile mais pas sur roues : il marche. Le principe est fort simple : Il avance droit devant lui à l’infini (aux piles prés

[youtube video=’LX_TNx-wKP0′ vparams=’rel=0|border=0′][/youtube]

Ca pique ! Et encore nous avons changer les pivots pour ajouter de la resistance mécanique. Avant il piquait nettement plus fort. Nous avons fait cette modifcation pour régler un autre problème. En effet au départ quand il avancait, la resistance des pivots était trop faible et la queue se pliait/dépliait légèrement. Cela provoquer un léger déséquilibre et deviait le scorpion de sa trajectoire.

Aujourd’hui, nous avons repris le bras de la dernière fois mais au lieu de suivre le manuel, nous avons élaboré le programme nous mêmes. Le résultat est meilleur. Comme vous pouvez le constater sur la vidéo suivante :

[youtube video=’yNX01F-Fwl0′ vparams=’rel=0|border=0′][/youtube]

L’étape suivante consistait à mettre en place le capteur colorimétrique. C’est à dire que le robot change d’action en fonction de la couleur de la sphère.

La balle est bleue, c’est ce qu’il attend… en conséquence il la laisse sur place après avoir dit qu’elle était bleue.

La balle est rouge, il n’en veut pas et la retire du support après avoir dit qu’elle était rouge.

Dans cette séance, nous avons attaqué le deuxième modèle. Il s’agit d’un bras articulé. Son but est de déplacer une balle d’un support à un autre. Cependant, si nous y sommes parvenus, le résultat n’est pas à la hauteur de nos espérances. Aussi on reprendra à la séance suivante et on ira plus loin.

Notre but est pour le moment de bien comprendre comment fonctionnent les moteurs et les capteurs grâce au logiciel fourni. Dans un deuxième temps nous passerons à Microsoft Visual Studio for Robotics qui peut piloter différents robots (et plus seulement celui de Lego). Il nous permettra de faire la même chose graphiquement mais exécuté par le PC et non plus le cerveau du robot. Et enfin nous pourrons écrire en .Net les modules que nous voulons. Cela pour passer de l’automatisme à l’intelligence artificielle. Si le coeur nous en dit, peut-être réaliserons nous des extensions en électronique.

[youtube video=’RDekVVj1pjY’ vparams=’rel=0|border=0′][/youtube]

Les prémices de l’activité robotique datent de Cybot. Un petit robot en kit que l’on achetait pièce par pièce chez le libraire. C’était un petit robot avec moteurs et capteurs qui était capable de se déplacer sur le sol en évitant les obstacles. Il pouvait aussi suivre une ligne tracée sur le sol ou suivre un rayon lumineux. Par contre il offrait peu de possibilités en terme de développement. En fait on ne pouvait que suivre le magazine. Même si à la fin on pouvait faire un soupçon de programmation.

Les prémices de l’activité robotique datent de Cybot. Un petit robot en kit que l’on achetait pièce par pièce chez le libraire. C’était un petit robot avec moteurs et capteurs qui était capable de se déplacer sur le sol en évitant les obstacles. Il pouvait aussi suivre une ligne tracée sur le sol ou suivre un rayon lumineux. Par contre il offrait peu de possibilités en terme de développement. En fait on ne pouvait que suivre le magazine. Même si à la fin on pouvait faire un soupçon de programmation.